GECE 교육사업

| [AI 프로젝트 코딩기술서] 상황에 따른 사자성어 추천 | |||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| 조회 수 : 926 | |||||||||||

|

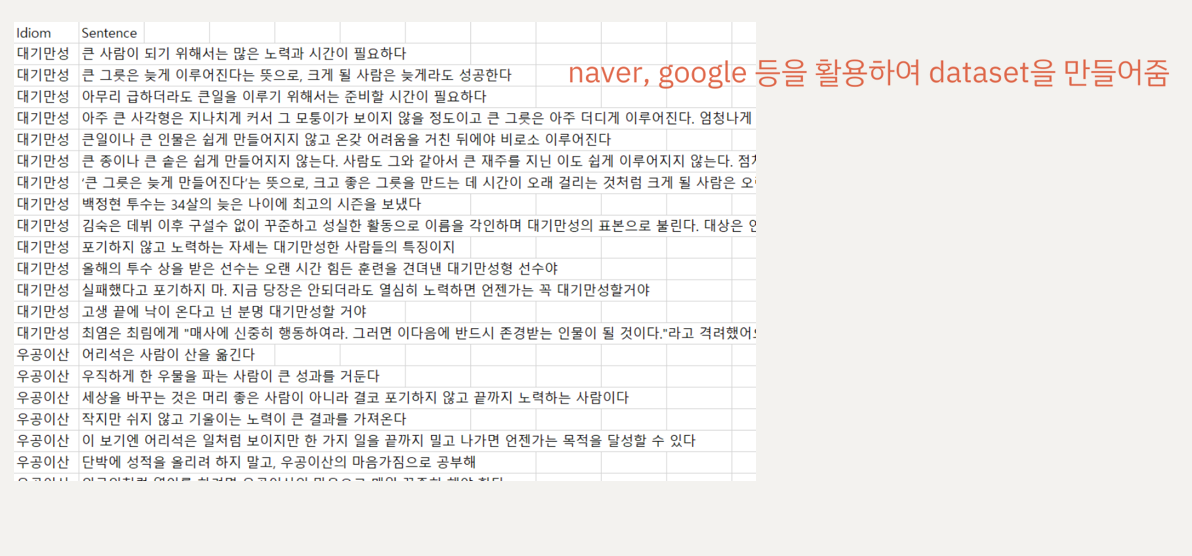

콘텐츠 소개(About Contents)· Kobert : 영어 약 33억개의 단어로 사전학습시킨 번역 모델인 Bert를 한국어에 사용할 수 있도록 만든 모델 · 학습된 kobert에 data를 이용하여 목적에 따라 파인튜닝을 하여 새로운 model 생성 · 상황에 따른 사자성어를 예측하는 model 생성

기획자(Planner)

|

|||||||||||